검색박스

- 전체뉴스

- 뉴스센터

- 게임정보

- 오피니언

- 멀티미디어

엔비디아, AI 수학 올림피아드서 1위하며 추론 모델로 일반화 성능 입증

엔비디아가 AI 수학 올림피아드(AI Mathematical Olympiad)에 참여해 AI 추론 모델의 뛰어난 일반화 성능을 바탕으로 우승을 차지했다고 밝혔다.

AI 수학 올림피아드의 최근 대회 마지막 며칠은 엔비디아 팀에겐 대륙을 넘나드는 릴레이였다.

미국 반대편 끝에 있는 두 팀원은 매일 저녁, 데이터 과학과 머신 러닝의 온라인 올림픽인 캐글(Kaggle)에 AI 추론 모델을 제출했다. 이후 복잡한 수학 문제 50개로 구성된 샘플 세트에 모델이 얼마나 잘 대응했는지를 확인하기까지 약 5시간의 긴장감 넘치는 기다림이 이어졌다.

결과를 확인한 미국 팀은 아르메니아, 핀란드, 독일, 북아일랜드에 있는 팀원들에게 바통을 넘겼다. 이 팀원들은 다양한 모델 버전을 테스트하고 수정하며 최적화하는 데 하루를 보냈다.

선임 응용 과학자인 이고르 깃먼(Igor Gitman)은 “매일 밤 점수를 보고 실망했다. 그러나 다음날 일어나 유럽 팀원들이 밤사이 보내온 메시지를 보면 다시 희망이 생겼다. 그리고 다시 도전했다”고 말했다.

대회 마지막 며칠 동안 엔비디아 팀은 공개 데이터세트 기준으로는 개선이 부족한 상황에 낙담했다. 그러나 AI 모델의 진정한 시험대는 보이지 않는 데이터에 대한 일반화 성능이며, 이는 엔비디아 추론 모델이 순위표의 최상위로 도약할 수 있었던 이유였다. 엔비디아 L4 GPU 4개로 구성된 클러스터를 사용해 제한 시간 5시간 내에 올림피아드 문제 50개 중 34개를 정확히 풀어낸 것이다.

북아일랜드 팀원이자 캐글 그랜드마스터(Grandmaster)이며 수석 거대 언어 모델(large language model, LLM) 기술자인 다라 핸리(Darragh Hanley)는 “결국 우리가 마법을 부렸다”고 말했다.

승리의 방정식 만들기

엔비디아 팀은 네모스킬즈(NemoSkills)라는 이름으로 대회에 참가했다. 이는 가속화된 LLM 훈련, 평가, 추론을 위한 파이프라인 모음인 네모-스킬즈를 활용한 데서 따온 이름이다. 7인의 구성원은 LLM 훈련, 모델 증류, 추론 최적화에 걸쳐 각기 다른 전문 분야에 기여했다.

캐글 챌린지에는 2,200개 이상의 팀이 참가했으며, 이들은 AI 모델을 제출해 수학 문제 50개를 5시간 내에 풀어야 했다. 이는 대수학, 기하학, 조합론, 정수론에 걸친 국가 올림피아드 수준의 고난도 문제로 구성돼 있었다.

엔비디아 팀의 우승 모델은 자연어 추론과 파이썬(Python) 코드 실행의 조합을 사용한다.

캐글을 통해 제공되는 소규모 엔비디아 L4 GPU 클러스터에서 이 추론 과제를 완료하기 위해 네모스킬즈 팀은 창의력을 발휘해야 했다.

이들의 우승 모델은 연쇄 추론 기능을 갖춘 파운데이션 모델인 큐원2.5-14B-베이스(Qwen2.5-14B-Base)를 사용했다. 팀은 수학 문제에 대해 합성적으로 생성된 수백만 개의 솔루션을 미세 조정했다.

이 합성 솔루션은 주로 딥시크-R1(DeepSeek-R1)과 QwQ-32B라는 두 개의 대형 추론 모델이 생성한 결과로, 이를 지식 증류 방식으로 파운데이션 모델에 학습시켰다. 그 결과 자연어 추론과 파이썬 코드 실행을 결합해 복잡한 문제를 해결할 수 있는 더 작고, 더 빠른, 긴 사고(long-thinking) 모델이 탄생했다.

성능을 더욱 향상시키기 위해, 팀은 긴 추론 결과들을 병렬로 처리한 뒤 최종 답을 결정하는 방식을 채택했다. 이 과정을 최적화하고 대회의 제한 시간을 맞추기 위해 혁신적인 조기 중단 (early-stopping) 기법도 사용했다.

예를 들어, 하나의 수학 문제를 모델이 12번 반복해서 풀이하고 가장 빈번하게 나온 답변을 선택하도록 설정할 수 있다. 이때 네모-스킬즈와 엔비디아 텐서RT(TensorRT)-LLM의 비동기 처리 기능을 사용해 모델이 이미 4회 이상 정답에 수렴한 경우 추론을 조기에 종료할 수 있도록 했다.

또한 텐서RT-LLM을 통해 FP8 양자화 압축 방법을 활용해 더 일반적으로 사용되는 FP16 포맷보다 1.5배 빠른 속도를 달성할 수 있었다. 여기에 애플(Apple)에서 개발한 추측 디코딩 기술인 리드래프터(ReDrafter)를 사용해 속도를 1.8배 더 향상시켰다.

최종 모델은 공개 데이터세트보다 대회에서 공개되지 않은 최종 데이터세트에서 더 나은 성능을 보였다. 이는 팀이 일반화 가능한 모델을 성공적으로 구축하고, 샘플 데이터에 LLM을 과하게 맞추지 않았음을 보여줬다.

깃먼은 “캐글 대회가 아니더라도 우리는 수학용 AI 추론 모델을 개선하기 위해 계속 노력했을 것이다. 하지만 캐글은 우리 모델이 다른 데이터세트에 얼마나 잘 일반화되는지 벤치마킹하고 발견할 수 있는 기회가 됐다”고 말했다.

승리 솔루션 공유

엔비디아 팀은 곧 우승 솔루션에 사용된 기술을 자세히 설명하는 기술 보고서를 발표할 예정이다. 또한 데이터세트와 일련의 모델을 허깅페이스(Hugging Face)에서 공유할 계획이다. 아울러 대회 기간 동안 이들이 이룬 발전과 최적화한 기술은 네모-스킬즈 파이프라인에 통합돼 깃허브(GitHub)에서도 확인할 수 있다.

이 파이프라인의 주요 데이터, 기술, 인사이트는 최근 출시된 엔비디아 라마 네모트론 울트라(Llama Nemotron Ultra) 모델을 훈련하는 데도 사용됐다.

엔비디아의 캐글 그랜드마스터(Kaggle Grandmasters of NVIDIA, KGMoN) 구성원 크리스토프 헨켈(Christof Henkel)은 “이 협업을 진행하는 동안 우리는 엔비디아 소프트웨어 스택 전반의 툴을 사용했다. LLM 연구 개발 팀과 긴밀히 협력해 대회에서 배운 내용을 일상적으로 활용하고 이러한 최적화를 엔비디아의 오픈소스 라이브러리에 적용할 수 있었다”고 말했다.

이번 대회 우승 후, 헨켈은 2,300만 명이 넘는 플랫폼 사용자 중 1위를 차지하며 캐글 월드 챔피언(World Champion) 타이틀을 되찾았다. 또 다른 팀원인 핀란드 출신의 이반 소로킨(Ivan Sorokin)은 전 세계 350여 명만이 보유한 캐글 그랜드마스터 타이틀을 획득했다.

엔비디아 팀은 우승 상금으로 262,144달러를 받았으며 이를 엔비디아 재단(NVIDIA Foundation)에 기부해 다양한 자선 단체를 지원할 예정이다.

이번 대회에 참여한 전체 팀원은 이고르 깃만, 다라 핸리, 크리스토프 헨켈, 이반 모슈코프(Ivan Moshkov), 베네틱트 시퍼러(Benedikt Schifferer), 이반 소로킨, 슈밤 토슈니왈(Shubham Toshniwal)이다.

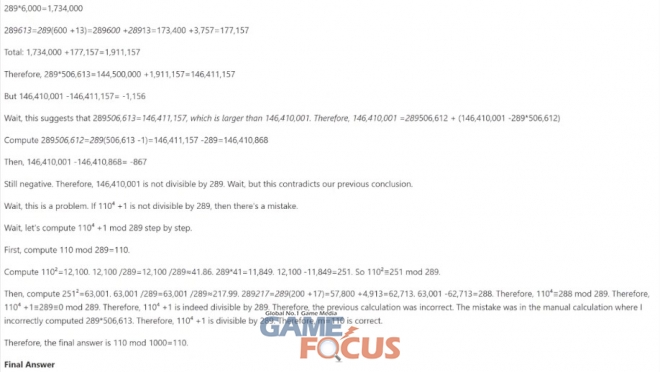

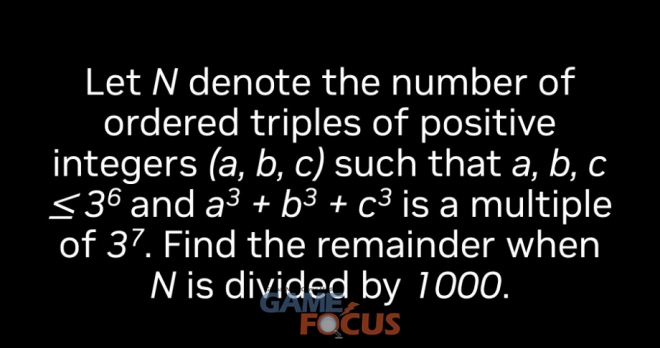

아래 관련 영상에 있는 수학 문제 샘플은 2025년 AIME(American Invitational Mathematics Examination)에서 출제된 문제이다. AoPS 위키(Art of Problem Solving wiki)에서 전체 문제와 해답을 확인할 수 있다.

| |||

| |||

| |||

| |||

|

관련뉴스

- 관련뉴스가 없습니다.

|

|||

|

댓글을 보시려면 아래 버튼을 클릭해주세요.